一、前言

在2025年的开头,DeepSeeK横空出世,无数媒体都在报道。目前用户可以在手机端下载应用,或者直接在网页体验。但体验过的用户发现,软件和网页经常会出现“服务器繁忙,请稍后重试”的提示,推测是被外部攻击,时不时崩溃。那么就可以尝试在本地计算机部署模型,离线使用。需要注意的是,部署在本地的是蒸馏版本(阉割版)。

二、环境

- 操作系统:推荐使用Linux、windows10、11或macOS。

- 硬件需求:最低配置:相当于GTX 1070及以上显卡+16GB内存+30GB存储;

推荐配置:NVIDIA GPU(RTX 3090或更高)+32GB内存+50GB存储。

三、安装Ollama

Ollama是一个开源的本地模型运行工具,可以方便地下载和运行各种开源模型。访问Ollama官网:https://ollama.com/,在下载时最好使用谷歌浏览器,有魔法的用上魔法,不然会出现无法下载的情况。

选择对应的版本进行下载

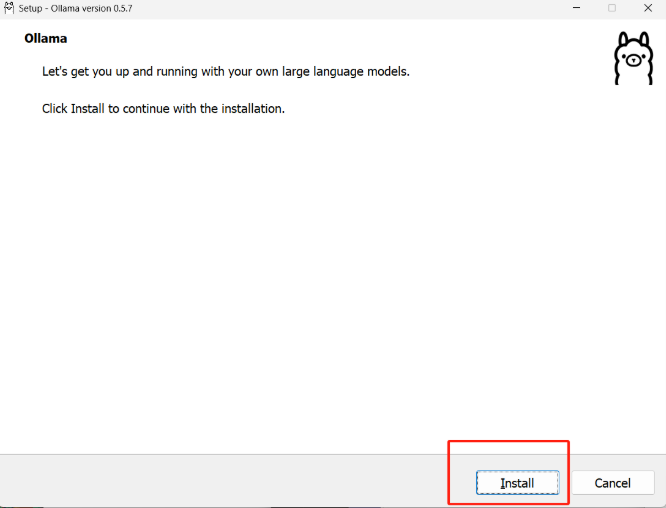

以管理员身份运行Ollama程序,点击install进行软件的安装,等待几分钟

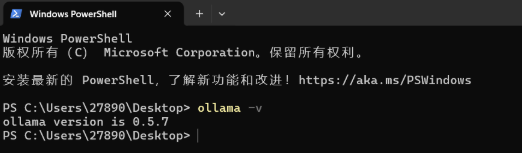

安装完成后win+R输入cmd调用命令行进入到命令模式,输入命令ollama -v查看是否安装成功,出现了版本号就说明安装成功。

四、部署DeepSeek模型

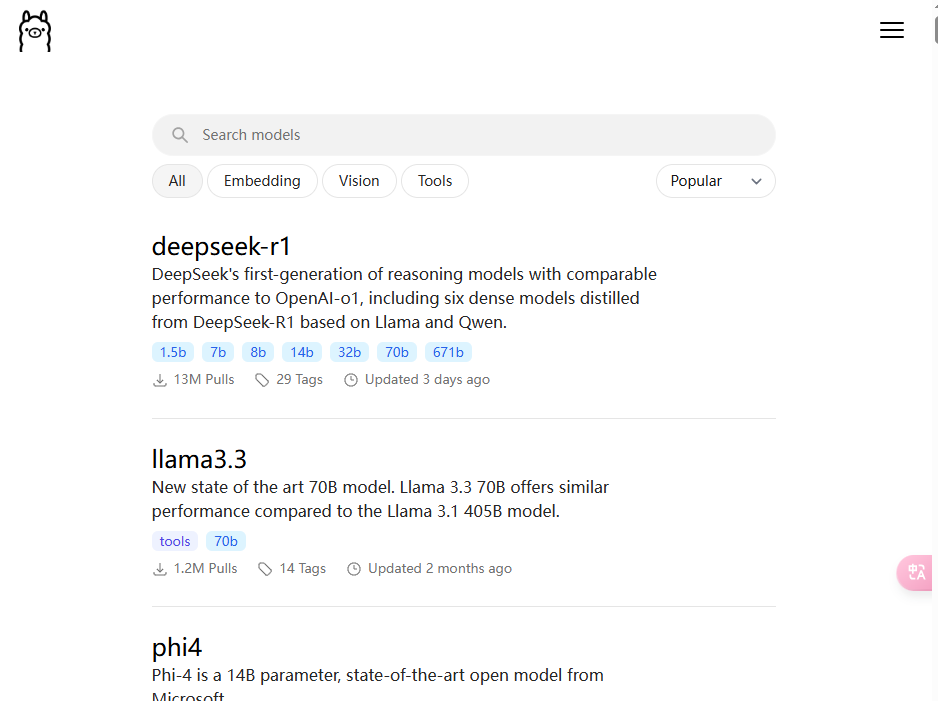

再次打开Ollama官网,选择Models的选项

进来后第一个就是DeepSeek-R1 的模型,点它

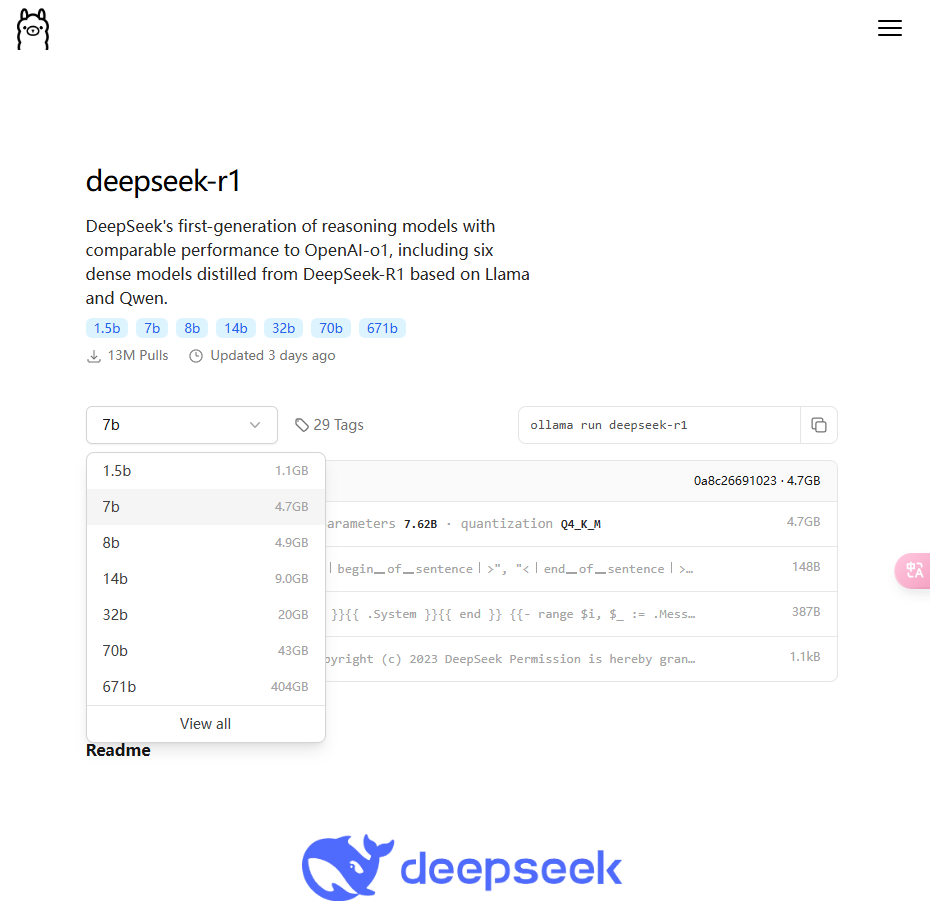

这里有许多版本模型,1.5b、7b、8b、14b、32b、70b、671b,版本越高对计算机配置的要求越高。

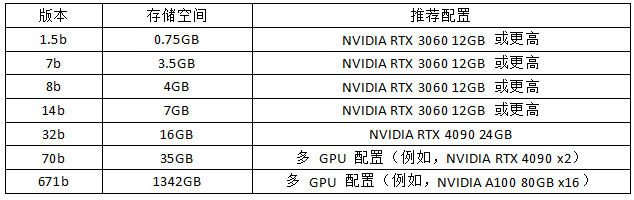

以下是各模型版本对应硬件配置的需求:

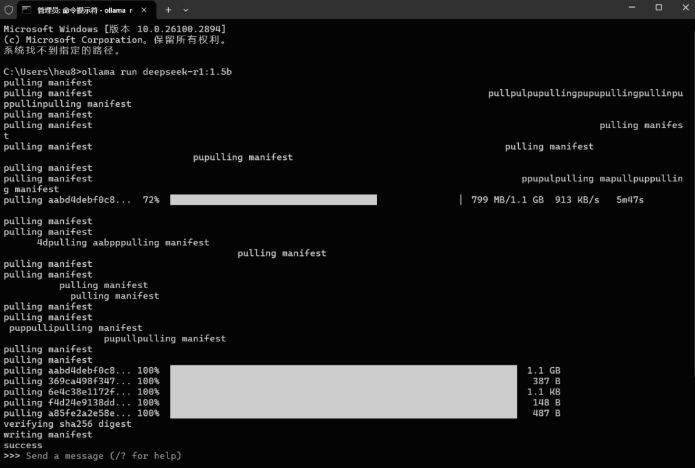

每个版本都有对应的安装命令,复制下来。然后win+R输入cmd进入命令模式,然后粘贴复制的命令。

等待下载完成,需要的时间可能不少。需要注意的是,其下载是默认存储在c盘里面的,请留好足够的空间。

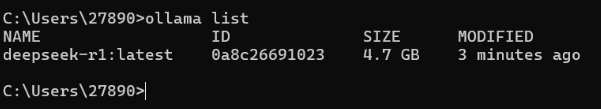

部署完成后,就可以直接在命令窗口输入问题。如果想退出对话,可以输入/bye来退出对话。退出后想重新进入对话的话,我们可以输入命令ollama list重新查看模型名字。

将这个模型的名字复制下来,然后回到命令行输入ollama run deepseek-r1:latest就可以重新进入对话了。